vLLM是一个由伯克利大学LMSYS组织开源的大语言模型高速推理框架,旨在提升实时场景下语言模型服务的吞吐与内存使用效率134。它是一个快速且易于使用的库,能够与HuggingFace无缝集成134。vLLM的核心是PagedAttention算法,这是一种新颖的注意力算法,通过引入操作系统的虚拟内存分页思想,显著提高了大型语言模型(LLM)的服务效率512。

此外,vLLM还支持FastAPI前端,扩展了OpenAI API接口,允许用户为每个请求自定义采样参数1516。

vLLM首次发布于2023年6月20日,并在2024年3月30日发布了0.4.0版本7。它的代码结构清晰,性能优异,因此获得了广泛关注,GitHub上的star数量达到了17k7。vLLM的实现采用了Python/C++/CUDA,这表明它不仅适用于学术研究,也适合在生产环境中部署和使用1719。

vLLM通过其创新的PagedAttention算法和模块化设计思路,有效地解决了大型语言模型在实时服务中的内存管理和吞吐量问题,使其成为了一个强大的工具,用于推动大型语言模型在生产环境中的高效部署和应用2522。

vLLM的PagedAttention算法是如何具体实现的,以及它如何提高大型语言模型的服务效率?

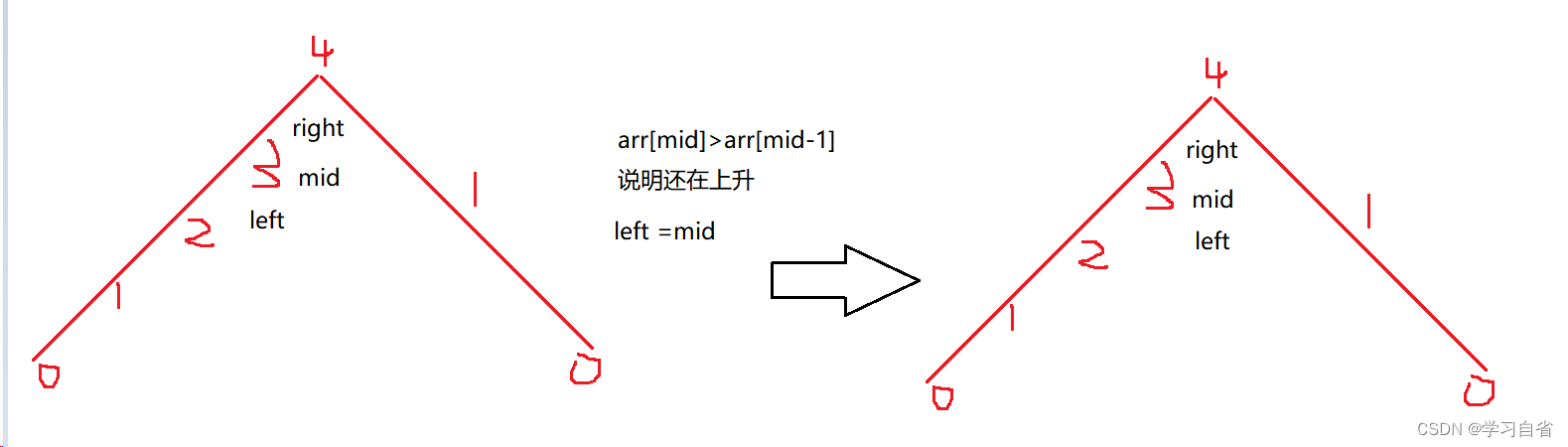

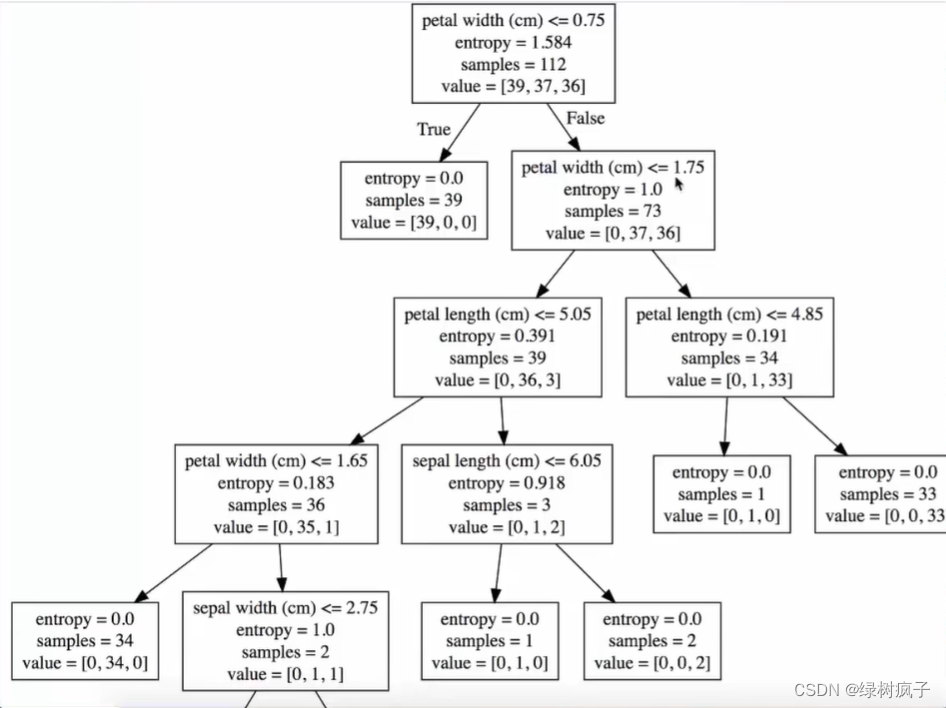

vLLM的PagedAttention算法是一种针对大型语言模型推理过程的优化方案,其核心思想是将每个序列的KV cache(键值缓存)分块处理,每块包含固定数量的token 28。这种设计灵感来源于操作系统中的虚拟内存和分页管理技术,旨在动态地为请求分配KV cache显存,提升显存利用率 30。通过这种方式,PagedAttention算法能够高效地管理attention中缓存的张量,实现了比HuggingFace Transformers高24倍的吞吐量 29。

具体实现方面,PagedAttention算法通过将自注意力机制的计算过程进行优化,利用Python、C++和CUDA等多种编程语言和技术,在源码中实现了这一算法 32。此外,该算法还采用了内存共享机制,极大地降低了复杂采样算法(如ParallelSampling和BeamSearch)的内存开销,使其内存使用量下降了高达55% 35。

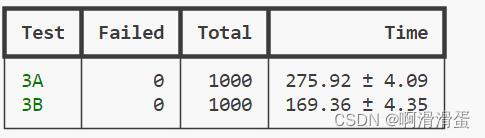

通过这些优化措施,PagedAttention算法不仅提高了大型语言模型的服务效率,还解决了GPU显存瓶颈问题,使得在self-attention计算中,计算速度比内存速度快得多的情况得到了改善 36。评估结果表明,vLLM可以将常用的LLM吞吐量提高了2-4倍,在延迟水平上与最先进的系统相当,并且在更长序列、更大模型和更复杂的场景下表现出了优异的性能 37。

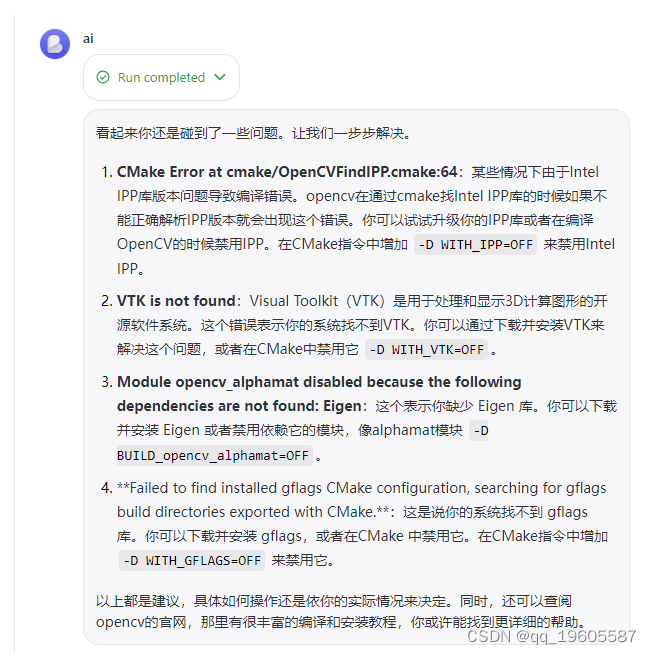

vLLM与HuggingFace集成的具体步骤和要求是什么?

vLLM与HuggingFace集成的具体步骤和要求主要包括以下几点:

-

模型架构兼容性:如果要集成的模型与vLLM中已有的模型架构相似,那么整个过程会相对简单39。这意味着用户需要先确认目标模型是否与vLLM支持的模型架构兼容。

-

信任远程代码:对于不在HuggingFace transformers库中的自定义模型,可以通过设置

trust_remote_code=True来启用对远程代码的信任,或者在CLI中使用--trust-remote-code标志40。这一步骤是为了确保vLLM能够安全地执行和使用这些远程模型。 -

环境变量配置:为了使用ModelScope中的模型而不是HuggingFace Hub上的模型,需要设置一个环境变量

$ export VLLM_USE_MODELSCOPE = True。同时,也需要使用trust_remote_code=True来启用对远程代码的信任45。这表明vLLM提供了灵活性,允许用户根据需要选择不同的模型来源。 -

实例化LLM对象:在vLLM框架中,首先需要实例化一个LLM对象。这是开始使用vLLM进行大模型推理和服务的基本步骤44。

-

调度策略分配:使用

PolicyFactory的get_policy方法为调度策略分配一个实例。这一步骤涉及到如何高效地管理和利用计算资源,以优化推理性能44。

vLLM与HuggingFace集成的过程涉及到模型架构的兼容性检查、远程代码信任的设置、环境变量的配置以及LLM对象的实例化和调度策略的分配。这些步骤和要求共同确保了用户能够在vLLM框架中无缝集成并使用HuggingFace模型,无论是现有的还是自定义的模型394044。

vLLM在内存管理和吞吐量方面相比其他框架有哪些显著优势?

vLLM在内存管理和吞吐量方面相比其他框架具有显著优势。首先,在吞吐量方面,vLLM提供了高达24倍的吞吐量提升,而无需进行任何模型架构的改变48。这一点在多个来源中得到了证实,例如与Hugging Face Transformers(HF)相比,vLLM的吞吐量高出14倍至24倍4951。此外,vLLM的吞吐量也比TGI高出2.2倍至3.5倍4951。

在内存管理方面,vLLM采用了PagedAttention技术,这种技术可以将注意力机制中的键和值存储在不连续的显存空间中,从而减少了显存碎片,提高了显存利用率50。这种内存管理技术使得大型语言模型在推理过程中能够更有效地利用计算资源,提高了推理速度。此外,vLLM的设计使得KV块存储在非连续物理内存中,进一步增加了内存管理的灵活性53。

尽管存在一些竞争框架,如Friendli Engine,它在LLM服务方面表现出色55,但vLLM通过其内部优化,在性能上仍然显着优于竞争对手54。vLLM在内存管理和吞吐量方面的显著优势主要体现在其高吞吐量和高效的内存管理技术上,这些优势使其成为大规模语言模型推理和服务的理想选择。

vLLM支持FastAPI前端的具体实现细节是什么,以及这如何扩展OpenAI API接口?

vLLM支持FastAPI前端的具体实现细节主要体现在以下几个方面:

-

服务提供系统:vLLM是一个端到端的服务提供系统,它具备FastAPI前端和基于GPU的推理引擎。这意味